视频来源(yuan):上(shang)观新闻(wen)(02:54)

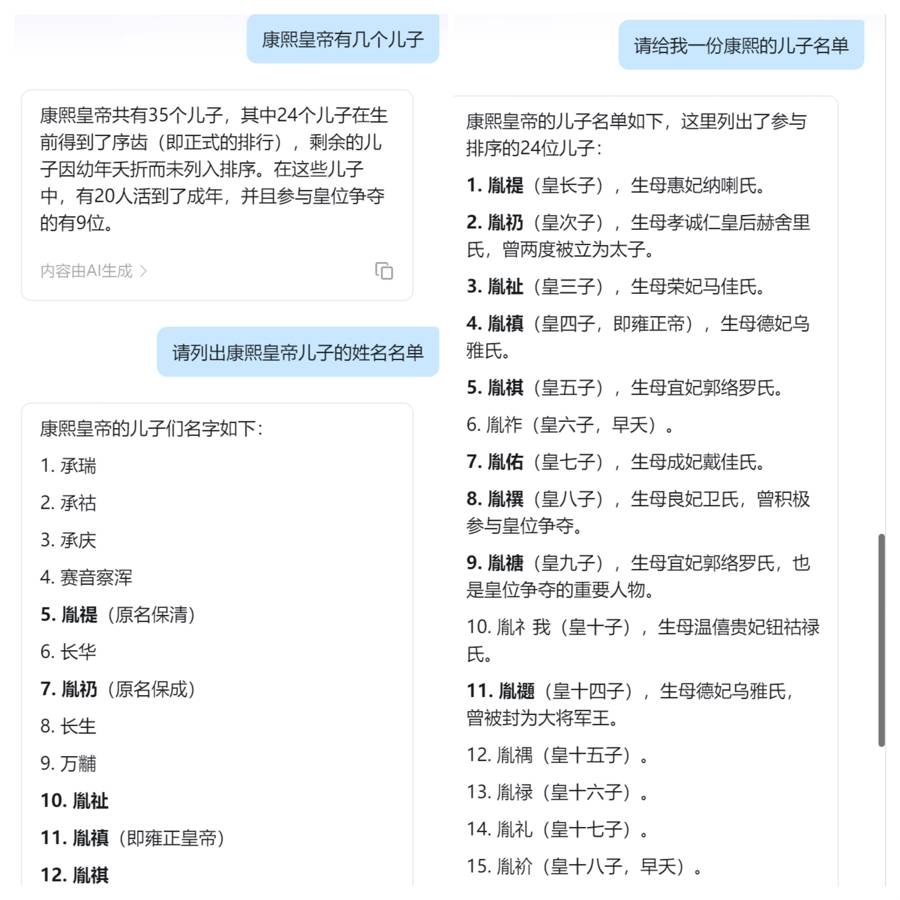

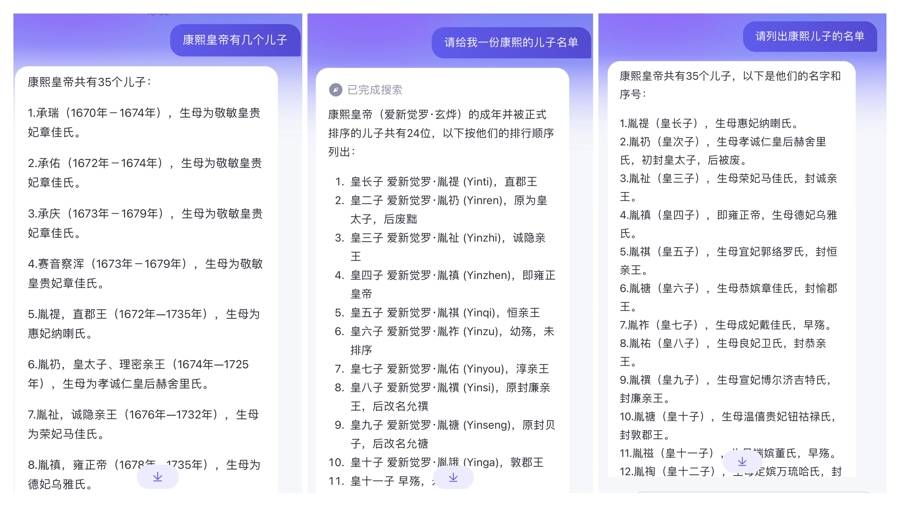

“康熙皇帝有几(ji)个儿子(zi)”“请列出康熙皇帝儿子(zi)的姓名名单”“请给我一份康熙的儿子(zi)名单”,将这三条(tiao)指令发送给人工智能大模型,猜猜答案是什么?

让人意外的结果出现了:不仅不同(tong)的大模型回(hui)答不一样,即便(bian)是同(tong)一个大模型,答案也有偏差(cha)。比(bi)如,有的答案统计了康熙所有的儿子(zi)数量,表示(shi)共有35人,包括正(zheng)式排序的儿子(zi)和早殇(shang)未排序的儿子(zi);有的只(zhi)列出了正(zheng)式排序的24个儿子(zi);还有的没有任何解释,列出了儿子(zi)的姓名,但顺序错乱(luan)……

不同(tong)大模型甚至同(tong)一个大模型的回(hui)答,并不一致。

为什么有明确答案的问题,会引发人工智能大模型的“错乱(luan)”?

“AI幻觉”颠倒黑白

“这正(zheng)是人工智能‘一本正(zheng)经胡说八道’的表现。”申城好网民专家、中国网安协会数据安全专家、上(shang)海临港数据评估有限公司总监宗良接受(shou)上(shang)海辟谣平台(tai)专访时指出,要注意人工智能大模型造假这一新趋势。

他(ta)介(jie)绍,人工智能“一本正(zheng)经地胡说八道”其(qi)实有个专有名词,叫(jiao)“AI幻觉”,即大模型提供了看似(si)合理但有错漏的答案。如果公众相信,可能上(shang)当受(shou)骗。

事(shi)实上(shang),在今年的世界人工智能大会上(shang),很多业界人士都提到了“AI幻觉”“可信大模型”等(deng)概念,并披露(lu)了多个人工智能大模型“造假”或“说谎”的案例,希望引起各界关注。

蚂蚁集团大模型应用部(bu)总经理顾进杰指出,目前公开的模型都存在不同(tong)类型的“AI幻觉”,大模型给出的结果甚至可能与真相截然相反。

比(bi)如,某研究报(bao)告称功能饮料(liao)中的维生素(su)、矿物质等(deng)对于运动后快速补充身(shen)体营养、消除疲(pi)劳具有一定的作用。但大模型在回(hui)答相关问题时,竟然表示(shi)相关微量元素(su)在增加疲(pi)劳上(shang)有一定的作用。

再比(bi)如,一般(ban)蚕可以活一个多月,其(qi)中从孵化到结茧根据季节不同(tong),大约是25天至32天,变成(cheng)蛹后有15天至18天,最后成(cheng)蛾是1天至3天。可有大模型在介(jie)绍这一规律(lu)时,将蚕结茧的时间与成(cheng)蛹的时间搞(gao)混了,输出的答案完全误导了询(xun)问者。

基于这些“AI幻觉”,专家呼吁,公众要谨慎看待大模型输出结果。虽然“百模大战”提供了获(huo)取信息的新方式,但不能轻信。事(shi)实上(shang),已经出现了大模型为了证明自己没有错而造假的现象。

比(bi)如,ChatGPT在谈及葡萄牙某银行破产事(shi)件时撒(sa)谎了,而且(qie)为了证实自己,它甚至编造出了所谓的信源(yuan)网址(zhi)。

大模型有短板,打标(biao)签刻不容缓

为什么大模型会给出错误的答案,成(cheng)为造假的源(yuan)头呢?

这与大模型的数据库、语料(liao)库、算法、检索能力乃至“理解能力”等(deng)有关。合合信息智能创新事(shi)业部(bu)总经理唐琪说,如果将大模型比(bi)喻为正(zheng)在疾驰的科技列车,语料(liao)库便(bian)是珍贵的“燃料(liao)”,因为大模型的训练源(yuan)自语料(liao)库。

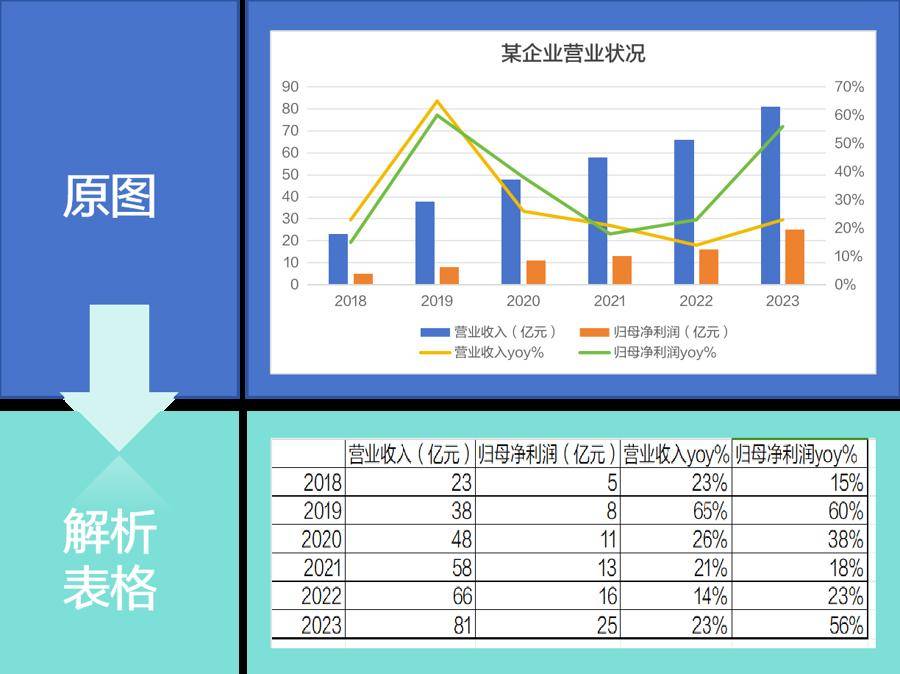

对国内的大模型开发企业而言,语料(liao)库短缺问题比(bi)较严峻。因为当前大模型数据库以英文居多,中文语料(liao)占比(bi)较低。还有,图表、复(fu)杂公式等(deng)元素(su)处理也是大模型语料(liao)处理中的“拦路虎”。在金(jin)融(rong)报(bao)表、行业报(bao)告等(deng)文档中,表格(ge)中的数据指标(biao)至关重要,但部(bu)分大模型并不能正(zheng)确“理解”表格(ge)里(li)行、列、单元格(ge)的意义(yi),导致大模型对整(zheng)个表格(ge)的识别结果产生误差(cha),最终得出错误的结论。

大模型要能够“读懂”图表。

基于此,在关注大模型“无所不能”时,也要关注大模型的短板。积极信号是,越来越多的大模型开发者开始关注“可信大模型”。有的开发出“大模型加速器”,帮助大模型理解图表等(deng)相对复(fu)杂的语料(liao)库,从源(yuan)头为大模型训练与应用输送纯净“燃料(liao)”;也有的在大模型开发中引入对应的技术,尽量消除“AI幻觉”,助力大模型跑得更快更稳。

不过,基于大模型存在短板、会不自觉地“造假”这一现状(zhuang),业界人士提出,有必要强化为AI生成(cheng)的内容“打标(biao)签”。

一方面,对于AI生成(cheng)的内容,大模型开发者应采取技术措施添加标(biao)签,对可能导致公众混淆或者误认的,更要显著标(biao)识。另一方面,信息发布平台(tai)要加强管理,督促上(shang)传信息者为AI生成(cheng)内容打标(biao)签,帮助公众区分。

普通人识别大模型造假,有诀窍

宗良提醒,AI幻觉本质上(shang)有两种,一种是完全的“胡说八道”,另一种是部(bu)分内容不准确或不完善。对后者而言,虽然不完全正(zheng)确,但仍有一定的参考价值。同(tong)时,也不能完全否定“AI幻觉”的价值,因为这也是AI创新的起点。

当然,从准确获(huo)取信息的角(jiao)度看,公众还是要对大模型输出结果或生成(cheng)的内容保持警惕。眼下,部(bu)分自媒体或不法分子(zi)开始批量通过人工智能生成(cheng)各类文章,乍一看似(si)乎与正(zheng)常的新闻(wen)报(bao)道无异,但真实性大打折扣,不少是为了博眼球之作。

不过,大模型的生成(cheng)结果仍旧有迹可循。公众可以通过部(bu)分关键词、行文格(ge)式等(deng),识别由人工智能生成(cheng)的文章。

其(qi)一,此类文章会在特定的关键词、用语、表述等(deng)方面形成(cheng)固化形式,有点类似(si)“小编给你(ni)说说某件事(shi),某件事(shi)是什么呢,小编给你(ni)说说”这样看似(si)合理却没有实际意义(yi)的内容。

其(qi)二(er),在人工智能生成(cheng)的文章中,会出现一些通用关键词,包括“以下是 XXX 的常见方法和手段”“通过上(shang)述手段”等(deng),这其(qi)实是大模型通过检索信息后进行的归纳。公众如果看到这些关键词,不妨提高警惕,不要轻信。

其(qi)三,需要各方携手合作,培(pei)养公众的数字素(su)养,提高公众对大模型造假等(deng)深度伪造的认识和辨别能力。

(原标(biao)题为《探“真”访谈:康熙到底有几(ji)个儿子(zi)?人工智能的回(hui)答出人意料(liao)》)